またCopilotに面白い機能が追加された。Copilotの「目」となるCopilot Vision(コパイロット ビジョン)だ。

Copilotが自分と同じものを見ながら会話できるので、本当に画面越しに人間と会話しているようだった。

この記事では、Copilot Visionのレビューや使い方、活用事例を紹介する。

未来を感じられる体験なので、皆さんもぜひ一度試してみてほしい。

とさか (登坂 圭吾)

- Copilotヘビーユーザー

- プライベートではCopilot Pro、会社ではMicrosoft 365 Copilot

- 著書:「Microsoft 365 Copilot AIで実現する仕事効率化」

- Xでも情報発信中→とさか

Copilot Visionのレビュー

Copilot Visionを使ってみた感想を良かった点とやや不満な点にまとめた。

Copilot Visionの良かった点:人と話してるみたい

Copilot Visionを使って驚いたのは、「これ」とかの指示語で伝わること。「これについて教えて」と言うだけで、Copilotが画面を読み取って解説してくれる。

自分もCopilotも同じものを見ているので、長いプロンプトを打たなくても一言で通じるのがすごく快適だった。

Teams会議で画面共有をしながら人間と会話しているような感覚だ。

「これって何だっけ。調べようにも言葉で説明するの難しい」という時に特に便利だ。もちろんGoogleレンズのような既存ツールもあるが、より直感的に素早く使える印象だ。

実際、日常生活でもさっそく役立った。先日、子どもと芋掘りをしているとき、何かの幼虫が土から出てきたのだが、Copilot Visionモードで聞くだけで「おそらくそれはコガネムシの幼虫ですね」と教えてくれた。

隣にいる友人に聞くような感覚

画面をまるっと共有するので、コネクタや認証などの下準備が不要なのが嬉しい。

あとスマホ版は、意外と雑に写してもカメラ画像をちゃんと認識してくれて、実用性が高いと感じた。

やや不満な点:テキスト会話でも対応してほしい

現状は、音声会話とのセットなのがやや残念に感じた。会話でやり取りできるのはめっちゃ速いが、自分が声を出して喋れる環境でないと使えないのがネック。

画面だけ共有して、テキストでも会話できるようになると嬉しい。

あと人によっては、「画面を見られている」ことについてプライバシーの懸念があるかもしれないが、Copilot Visionは終了後にデータをすべて放棄することが明記されているし、こちらが明示的にオンしない限り起動しないので、個人的にはそこまで気にならなかった。

Copilot Vision(コパイロット ビジョン)とは

Copilot Visionは「AIの目」

Copilot Visionは、AIに“目”を持たせる機能だ。

画面の表示内容やカメラ映像をCopilotが“見る”ことで、その情報をもとに分析・支援ができる。

ただし、すべて自動的に見ているわけではなく、ユーザーが明示的に許可・開始するオプトイン仕様だ。セッション終了後、画像・音声などは保存されず消去される設計になっているのでプライバシーの点でも安心だ。

Copilotとの関係は?

Copilot Visionは、Copilot本体(MicrosoftのAIアシスタント群)の「拡張機能」の一部である。

Copilot自体は主にチャット・テキストベースの対話、検索、生成を担い、Visionはその上で“視覚情報”を取り込むモードだ。

つまり、Copilot だけではできなかった、「見ながら解説」「カメラ画像をライブで見ながら説明」などを、Visionが補う。

Copilot全体の使い方については、こちらの記事が参考になると思う↓

利用できる条件

最初は米国、Copilot Proユーザーから利用が始まったが、今は日本の一般ユーザーにも展開されているようだ。

Copilot Visionは、

- Microsoft Edge

- スマホアプリ

- Windowsアプリ

で使える。

ただし現時点では、法人向けCopilotでは使えないと公式サイトに書かれてある。筆者も職場で試したがやはり使えなかった。

有料版Copilotを使い始めた方に、書籍「Microsoft 365 Copilot AIで実現する仕事効率化」がおすすめ。スマホでも読みやすい電子書籍で、かつ事例も具体的。一度読んでおくと今後の伸びが違う。

EdgeでCopilot Visionを使う

では、Copilot Visionの使い方を見ていこう。

まずは、Microsoftのブラウザ「Edge」でCopilot Visionを使う方法を解説する。

起動方法・使い方

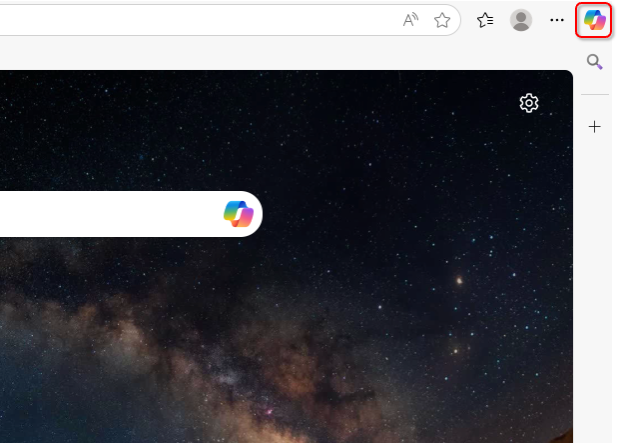

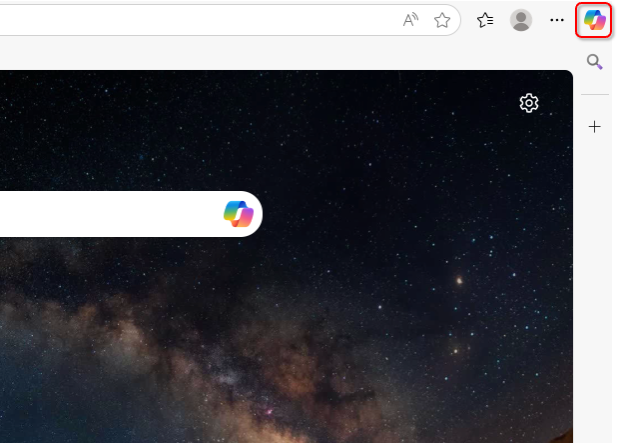

Edge右上の「Copilot」アイコンをクリック。

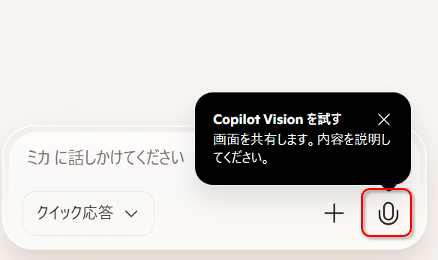

サイドバーにCopilotが立ち上がるので、右下の「マイク」アイコンを押す。

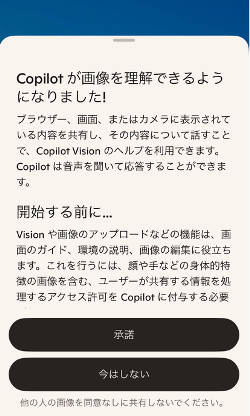

初回は、プライバシーに関するポップアップが出るので、「承諾」を押して進む。Copilot Visionは画面を見るという特性上、ユーザーが許可して初めて使える。画面データを保存するわけではないのでご安心を。

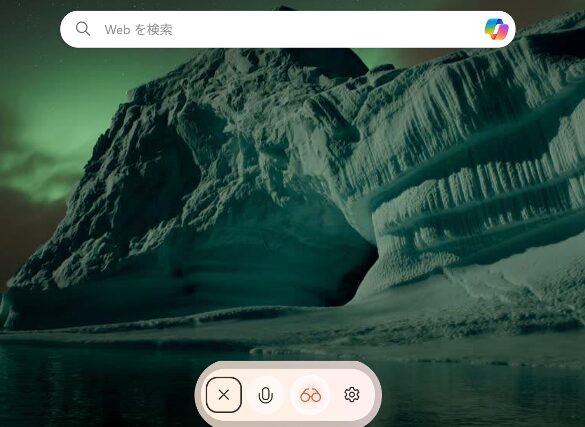

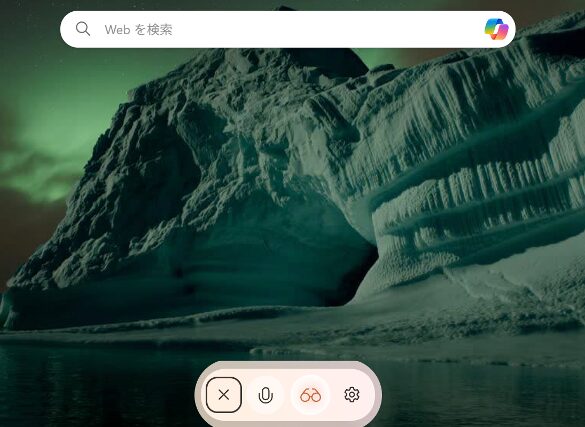

Copilotとの音声会話モードが立ち上がった。

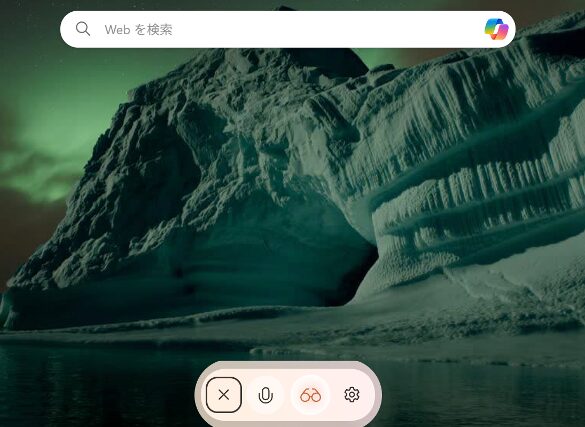

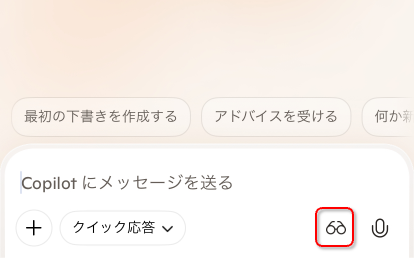

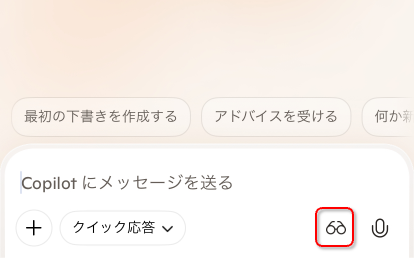

Copilot Vision(音声会話)起動中は、画面下部にメニューバーが出る。メガネのアイコンが、「Copilot Vision」起動中の目印だ。(アイコンを押せば、Copilot Visionをオフにもできる)

起動したら、あとはCopilotと自然に会話するだけ。非常に直感的に使える。

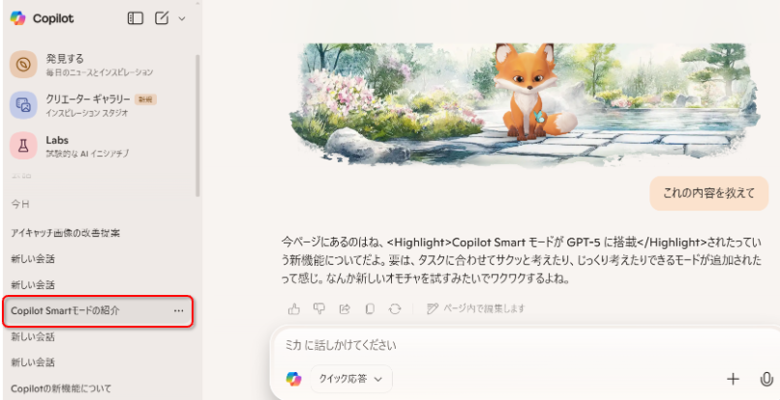

また、×ボタンで音声会話を終了したあと、Copilotとの会話履歴も見ることができる。

なお現状(2025年9月)では、Copilot Visionは音声会話とのセットになる。テキストでのやり取り中には使えない。

EdgeのCopilot Vision活躍事例

Edgeでの活用事例を具体的付きでまとめた。

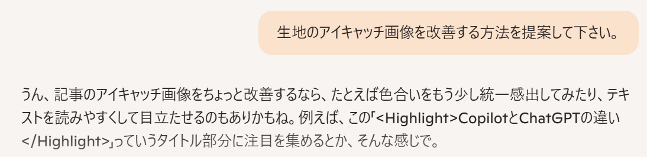

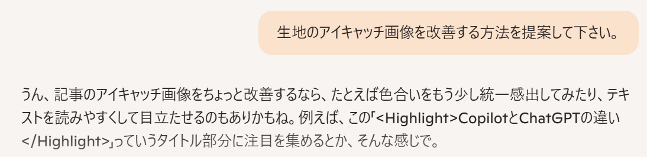

画面を見せてながらアドバイスをもらう

実際の画像を見せながら、会話することができる。文章だと伝えにくいようなことも簡単に伝えられる。

例えば、自分のブログ記事の画像を見せながら、「ブログのアイキャッチ画像の改善を提案して」と聞いてみた。

会話履歴はこんな感じ↓

提案内容の質はさておき、画面上の「Copilot」や「 ChatGPT」というテキストをちゃんと読みとっていることが分かる。

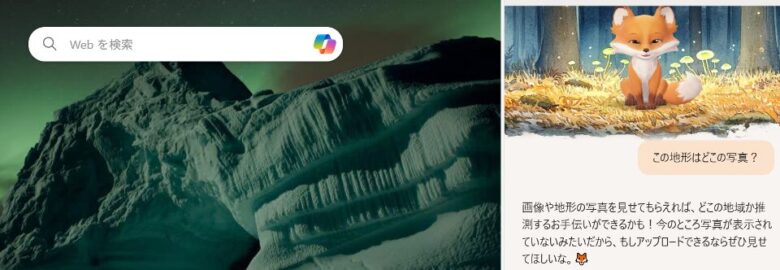

画像が何か解説してもらう

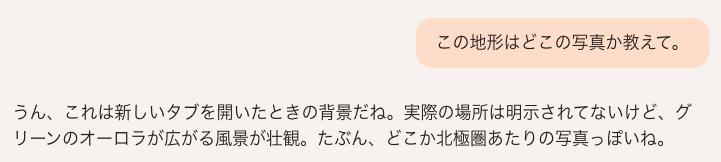

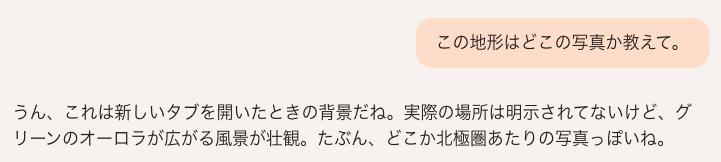

これ何の画像だろう?というときに、さっと画像を共有できる。

例えば、Edgeのトップ画像について、「これどこの写真?」と聞いてみた。

残念ながら明確な答えは返ってこなかったが、画面を認識し、推測を述べてくれた。

「これ」とか「この」という指示語だけで意図を汲み取り、答えてくれるのは驚異的だ。Teamsで画面共有をしながら人間と会話しているような感覚だ。

いちいち具体的に指示しなくても、自分が見ているものをCopilotと共有できる。

ちなみに、Copilot Visionを起動せずにサイドバーのCopilotに尋ねてみると、画像を認識することができなかった。やはり、ユーザーが明示的にCopilot Visionを起動させて初めてCopilotは画面を読み取れるようだ。

Webページの中身を教えてもらう

WebページについてCopilot Visionに教えてもらうことも可能。

あるページを開いた状態で、「このページの内容について教えて」と言うと、概要を教えてくれる。

ちょうど私は一人で昼食をとっていたが、両手が使えない状態でもCopilotと会話しながら記事の内容を把握することができた。会話なので聞きたいことを深堀りして尋ねることもできる。

驚いたのは、Copilotが自動で該当箇所までスクロールしたこと。Copilotが注目している箇所にはハイライトが付く。

自分でスクロールしなくていいのか

ただし、自分の意図とずれた答えを返してくることもあった。会話だとつい、こちらの指示が適当になってしまう点には注意だ。

操作方法などを教えてもらう

慣れていないツールについて、画面を見せながら教えてもらうことが可能だ。

例えば、Loopを開いた状態で、「ワークスペースって何?」と聞いてみた。

Copilotが画面の「ワークスペース」をハイライトし、「ワークスペースとは、、、」と概要を教えてくれた。

わからないことがあったとき、テキストで検索するより圧倒的に速いと感じた。

スマホでCopilot Visionを使う

次はモバイル版のCopilot Vision。スマホのカメラがAIの目になるので、より柔軟な使い方が可能だ。

スマホでの起動方法と使い方

Copilotアプリを起動し、入力ボックスのメガネアイコンから使える。

初回は確認画面が出るので「承諾」を押す。

すると音声会話モードが立ち上がり、画面はカメラ画像がライブで表示される。

あとは、Copilotに話しかけるだけ。非常に簡単に使える。

ちなみにこのときは、まだ何も言ってないのに「お、これはダイソンの扇風機ですね〜」と言ってきてびっくりした。本当に即座に画像を認識し、世の中の情報と結びつけていることが分かる。

Copilotけっこうおしゃべりだな

スマホでの活用事例

ではスマホ版Copilot Visionの活用事例も紹介。

実物を解説してもらう

身の回りで気になったものを、スマホをかざして解説してもらおう。

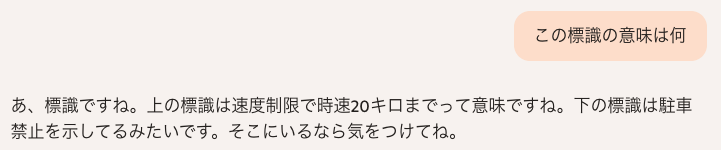

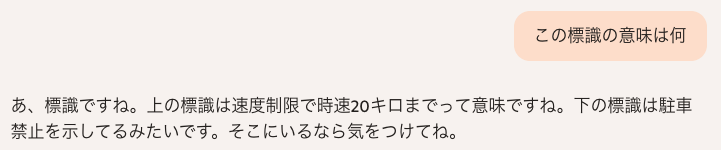

筆者も試しに、道路標識の意味について聞いてみた。

夜、歩きながら使ったのでかなりブレている。

会話履歴↓

こんな画像でもちゃんと読み取っているが、30を20と読み間違えたようだ。使うときは、できるだけブレないようにしたほうが良さそうだ。

最後に一言付け足してくるあたりがCopilotらしい

メニュー表や看板の読み取り

海外旅行でかなり助かりそうなのが、メニューや看板の翻訳だろう。

試しにフランス語のメニューを見せながらメニューの内容を聞いてみたが、機械的に翻訳するわけではなく、適当にピックアップしながら教えてくれたり、おすすめを教えてくれる点が面白かった。

翻訳しながらアドバイスもくれるガイドさんのようだ。

食材から献立を考えてもらう

冷蔵庫の中身をCopilot Visionで写しながら「料理のメニューを考えて」と聞いてみた。

すると、「人参や玉ねぎ、レタスがありますね。シンプルに野菜スープはどうですか?」と提案してくれた。

冷蔵庫にあったのは使いかけの玉ねぎだったが、ナチュラルに認識していてすごいと感じた。

自分は献立にいつも悩んでしまうので、将来的にも料理のサポートには期待したい。

Copilot Visionの注意点

プライバシーについて

この記事でも何度か言及しているが、画面やカメラ画像をそのまま見せることから、プライバシーへの懸念が挙がるだろう。

ただし、Microsoft公式サイトには、「ユーザー入力、画像、ページ コンテンツはログに記録または保存されません。」と明確に記載されている。

Copilotが”見た”ものはセッション中にだけ使われ、終われば削除されるので安心だ。

とは言え、使用中はクラウドにアップロードして処理されるだろうから、リスクはゼロではない。個人情報や機密情報はできるだけ映らないよう注意するに越したことはないだろう。

商用ユーザーは利用できない

現時点(2025年9月)で、Copilot Visionは 商用アカウント(Microsoft Entra ID)では無効で、個人用Microsoftアカウントでのみ利用できる。

背景には「セキュリティ懸念」「情報漏洩リスク」がゼロではないことが推測される。

会社PCで試そうとして「使えない…」となる人は多い。これは仕様なので注意だ。

クリックなど操作はできない

Visionはあくまで「画面を見て解説する」だけ。ユーザーに代わってクリック・入力などの操作はできない。

ただし「ここをクリックして」「このボタンを押す」といったガイド用のカーソルを表示することは可能。

つまり「代行作業員=エージェント」ではなく「ナビゲーター」として使うのが正しい。

データ通信量について

スマホでCopilot Visionを使う際、カメラ画像をクラウドへアップロードするため、通信量が発生する。

連続的な動画を送ると結構な通信量になるのでは?と思ったが、筆者が外でモバイルデータ通信でCopilot Visionを使っても、思ったより通信量は少なかった。

おそらく、動画ではなく、フレーム(静止画)を取得して送信しているのだろう。

ただ、普通のテキストよりは通信量が多いだろうから、可能ならWi-Fi環境で使うのがベター。

まとめ

これまでの生成AIは主に「脳」の機能を持っていた。それが音声会話機能で「口」と「耳」を持ち、Copilot Visionでついに「目」を持つことになった。

どんどん、人間に近づき、できることが増えていく。

将来はこれらの機能が当たり前の世界になるはずだ。今から使いこなすスキルを磨いておこう。

Copilotを使い始めた人は、使い方を書籍で体系的に学ぶことも近道になる。こちらの記事にCopilotのおすすめ本をまとめたので、参考にしてほしい。